Como vimos anteriormente, desde 2005 en adelante hay una serie de servicios y herramientas tecnológicas se expandieron rápidamente, sobre todo:

- Redes sociales/Web 2.0

- Internet móvil/Smartphones

- Internet-de-las-Cosas

Estos elementos coincidieron en el tiempo, dando lugar a la generación de una enorme cantidad de datos en formatos electrónicos (entradas de texto, fotos, videos, registros automáticos de sensores), muy superior a la de los años anteriores. Se calcula que en los dos últimos años se ha generado el equivalente a todos los datos generados desde el origen de la humanidad. A este fenómeno, esta verdadera "explosión de datos", se ha dado por llamar "Big Data" (http://gestionyti.blogspot.com.es/2015/06/big-data-los-origenes.html), y es una de las fuerzas que dará forma a la industria en los próximos años.

Hasta ese momento las empresas habían explotado las tecnologías de "análisis predictivo", basados en los datos del negocio que se obtenían, en general, a partir de los sistemas de gestión o de sistemas de operaciones ad-hoc. De allí surgían los primeros sistemas de "Data Mining", tendientes a obtener correlaciones entre los datos, para determinar tendencias de ventas, preferencias de clientes u optimizar la gestión de riesgos.

El sector de banca, seguros y tarjetas de crédito, por ejemplo, fue un pionero, desde la década de 1980, en explotar el historial de los clientes, para determinar probabilidades de fraude o de default en los pagos, estableciendo un scoring automático que determinaba qué clientes eran adecuados para recibir determinados productos financieros.

Pero hay diferencias con la época actual del "Big data":

1. El volumen de los datos adquiridos es muchísmo más grande y diversa. La explosión de la movilidad, por ejemplo, nos da una enorma cantidad de información sobre la localización y hábitos de las personas (por dónde se mueve, con qué frecuencia hace ciertas actividades, etc). Las redes sociales permiten establer gustos, preferencias, fobias y toda una serie de características "sociales" de los individuos. Y no sólo características de las personas: podemos cruzar estos datos con los obtenidos por sensores ambientales, medidores del uso de servicios públicos y muchos otros.

2. La naturaleza de los datos adquiridos es diferente. En los ´90 los sistemas de Data Mining se alimentaban con registros procesados electrónicamente, muchas veces cargados a mano, en formatos predecibles y siguiendo estructuras de bases de datos, lo que llamamos "datos estructurados." Para explotar los datos era necesario "estructurar" y "limpiar" los mismos. Actualmente, los sistemas con capaces de procesar y extraer conocimiento de "datos no estructurados" en los que se incluyen textos no lineales, audio, imágenes, video, muchas veces sin necesidad de un proceso de clasificación y "limpieza" previa.

2. La naturaleza de los datos adquiridos es diferente. En los ´90 los sistemas de Data Mining se alimentaban con registros procesados electrónicamente, muchas veces cargados a mano, en formatos predecibles y siguiendo estructuras de bases de datos, lo que llamamos "datos estructurados." Para explotar los datos era necesario "estructurar" y "limpiar" los mismos. Actualmente, los sistemas con capaces de procesar y extraer conocimiento de "datos no estructurados" en los que se incluyen textos no lineales, audio, imágenes, video, muchas veces sin necesidad de un proceso de clasificación y "limpieza" previa.

3. La inmediatez con que se obtienen los datos, practicamente podemos tener una radiografía de las tendencias sociales a cada instante, en tiempo real. Podemos medir los desplazamientos de masas, las preferencias por grupos, las noticias o eventos que causan impacto positivo o negativo en cuestión de segundos. Esto requiere que los análisis, para que sigan siendo útiles, se realizan prácticamente sobre los datos "en crudo", sin tiempo para prepararlo, depurarlos y determinando acciones sobre tendencias que pueden durar unos minutos.

Las empresas se dieron cuenta de que podían aprovechar esta disponibilidad inmediata de tantos datos para desarrollar nuevos sistemas de soporte a la decisión, para tomar decisiones operativas, en tiempo real, sobre promociones, mejoras de servicio y otros, generando una ventaja competitiva. Quien detectara más rápido una tendencia, sobre todo en el mercado de consumo masivo, tiene más posibilidades de aprovecharla y obtener beneficio sobre la competencia.

La industria reaccionó ofreciendo una amplia gama de soluciones para el tratamiento y análisis de datos masivos. Actualmente existe una gran competencia entre diferentes tecnologías y modelos ofrecidos por empresas desarrolladoras de aplicaciones, bases de datos, soluciones de almacenamiento y otros. Muchas de estas aplicaciones evolucionaron de técnicas y modelos predictivos desarrollados en los años ´80, dentro del área de Inteligencia Artificial.

En este momento, Big Data, entendido como la explotación de los datos que las empresas obtienen de su contexto de negocios (datos de clientes, proveedores, medio ambientales), combinados con datos que se pueden obtener públicamente (lo que hoy se llama Open Data), o adquiridos a terceros que los generan, es una de las principales demandas desde el negocio a las áreas de Sistemas.

Las aplicaciones derivadas de la disponibilidad de estos datos son múltiples:

En este momento, Big Data, entendido como la explotación de los datos que las empresas obtienen de su contexto de negocios (datos de clientes, proveedores, medio ambientales), combinados con datos que se pueden obtener públicamente (lo que hoy se llama Open Data), o adquiridos a terceros que los generan, es una de las principales demandas desde el negocio a las áreas de Sistemas.

Las aplicaciones derivadas de la disponibilidad de estos datos son múltiples:

- Predecir/Anticipar el comportamiento de los clientes, basado en su historial de compra, perfil demográfico, etc (vital para hacer promociones personalizadas)

- Fidelización/Servicio al cliente: mejorar la experiencia del cliente en el uso de los productos/servicios de una compañía, adaptándose a sus preferencias y gustos

- Optimización de procesos: planificar el flujo de trafico de coches o de personas, para optimizar la frecuencia de servicios públicos como trenes, metro, autobuses. Mejorar los canales de distribución, gestionar emergencias localizadas, como se puede ver en este ejemplo (http://dynamicinsights.telefonica.com/blog/488/smart-steps-2)

- Colaboración/Compartición de recursos: algoritmos para encontrar recursos que se adecuan a una necesidad del consumidor.

Y todo esto tomando millones de pequeñas decisiones en tiempo real, basado en un flujo de datos inmediato que va cambiando permanentemente.

Los pioneros en este campo son las empresas que brindan servicios digitales como Google, Facebook, Twitter y otras. Pero también las empresas tradicionales están transformado sus procesos para introducir conceptos de Big Data en la toma de decisiones. Esto está afectando, sobre todo, a empresas de consumo masivo, de servicios públicos y al propio sector de Gobierno. Prácticamente ningún sector queda exento de este fenómeno. Toda organización de un cierto tamaño está obligada a analizar el impacto de la "explosión de datos" en su negocio, tanto para defender su posición como para obtener ventajas competitivas.

Pero adaptarse a este nuevo mundo, no implica sólo adquirir un nuevo paquete de software, tiene muchas más implicancias. A saber:

En síntesis, el Big Data no sólo ha introducido una nueva capa de software en la organización, sino que también tiene un alto impacto en el diseño de las infraestructuras, del mapa de aplicaciones y la estructura organizativa de la propia área de Sistemas. Cualquier arquitectura de sistemas de una empresa en la actualidad debe considerar todas sus aristas.

Los pioneros en este campo son las empresas que brindan servicios digitales como Google, Facebook, Twitter y otras. Pero también las empresas tradicionales están transformado sus procesos para introducir conceptos de Big Data en la toma de decisiones. Esto está afectando, sobre todo, a empresas de consumo masivo, de servicios públicos y al propio sector de Gobierno. Prácticamente ningún sector queda exento de este fenómeno. Toda organización de un cierto tamaño está obligada a analizar el impacto de la "explosión de datos" en su negocio, tanto para defender su posición como para obtener ventajas competitivas.

Pero adaptarse a este nuevo mundo, no implica sólo adquirir un nuevo paquete de software, tiene muchas más implicancias. A saber:

- Infraestructuras: es necesario planificar adecuadamente la infraestructura para capturar, almacenar y procesar este volumen de datos constantes que se recibe del medio. Actualmente existen muchas alternativas para conseguir resultados a unos costes razonables. La hiperconectividad actual y los servicios en la nube, permiten "paralelizar" el procesamiento de datos en redes de muchos servidores colaborativos, sin tener que cargarse de grandes equipos. El almacenamiento también se puede usar durante el tiempo necesario, pagando sólo por lo que se usa, sin cargarse de grandes activos.

- Métodos de análisis: uno de los factores importantes es calcular el margen temporal en el cual el resultado de un análisis de los datos es relevante para el negocio. Por ejemplo, para predecir el próximo click de un cliente en una página de comercio electrónico y ofrecer una promoción acorde, tenemos un margen de segundos o fracciones de segundo. Para optimizar la frecuencia de los trenes, probablemente minutos. La determinación del método de análisis, y por tanto, su grado de exactitud, va determinada por ese margen temporal. Esto condiciona también la selección del software.

- Calidad de los datos: el hecho de disponer de muchos datos no garantizan que estos estén correlados con el objetivo. Puede que estos datos no tengan influencia en el resultado que se busca o que estos tengan un nivel de "ruido" o "distorsión" como para que el análisis sea confiable. Adicionalmente, pueden faltar ejemplos suficientes en cada categoría o que falte el datos clave para obtener el resultado. Esto requiere de preparación, testing y, muchas "hacer inferencias" o "llenar los huecos" estadísticamente hablando de los datos. Otras veces buscar fuentes complementarias de datos: Open Data, o comprar Data Sets ofrecidos en partnership por terceros.

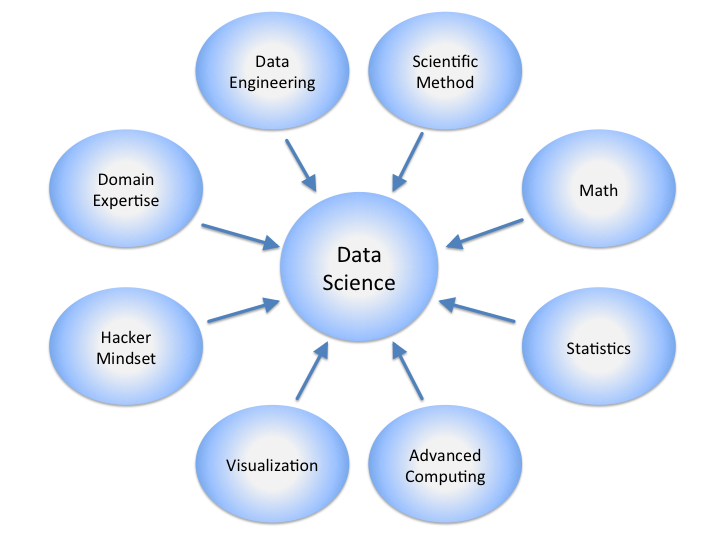

|

| Disciplinas relacionadas con Data Science Gráfico de Calvin Andrus https://upload.wikimedia.org/wikipedia/commons/4/44/DataScienceDisciplines.png |

En síntesis, el Big Data no sólo ha introducido una nueva capa de software en la organización, sino que también tiene un alto impacto en el diseño de las infraestructuras, del mapa de aplicaciones y la estructura organizativa de la propia área de Sistemas. Cualquier arquitectura de sistemas de una empresa en la actualidad debe considerar todas sus aristas.

No hay comentarios:

Publicar un comentario